摘要

高效率綠機房節能手法探討

因技術演進及應用需求增加,雲端運算、虛擬化、智慧節能、巨量分析等功能不斷增加,電腦機房之設置走向高密度、高穩定性、高效率、高彈性、可擴充性,但也高耗能的趨勢,設計一個節能又穩定的機房為一重要的課題。 電腦機房空調供應方式分為冷熱通道分離、風管送風、自然冷卻及液體冷卻等方式,各有其優缺點,本文分析目前全球電腦機房之機房設計架構,找出未來最佳的設計方向,使能達到省能、安全、穩定之硬體設施。

前言

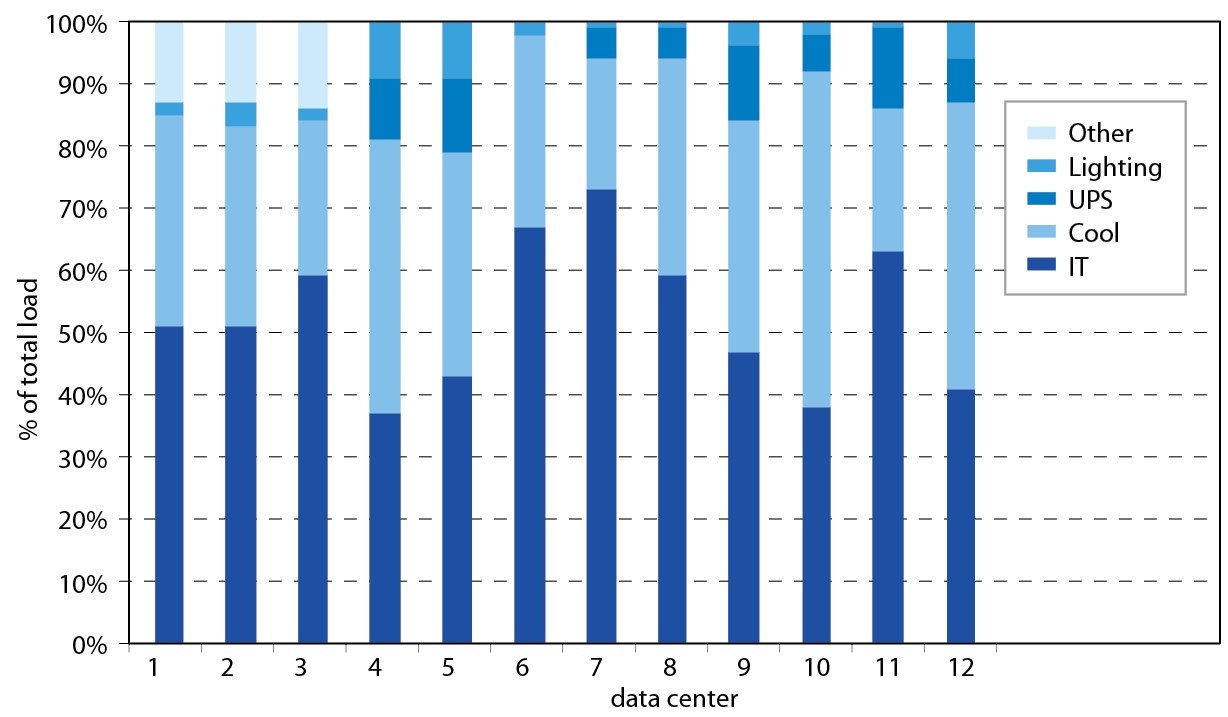

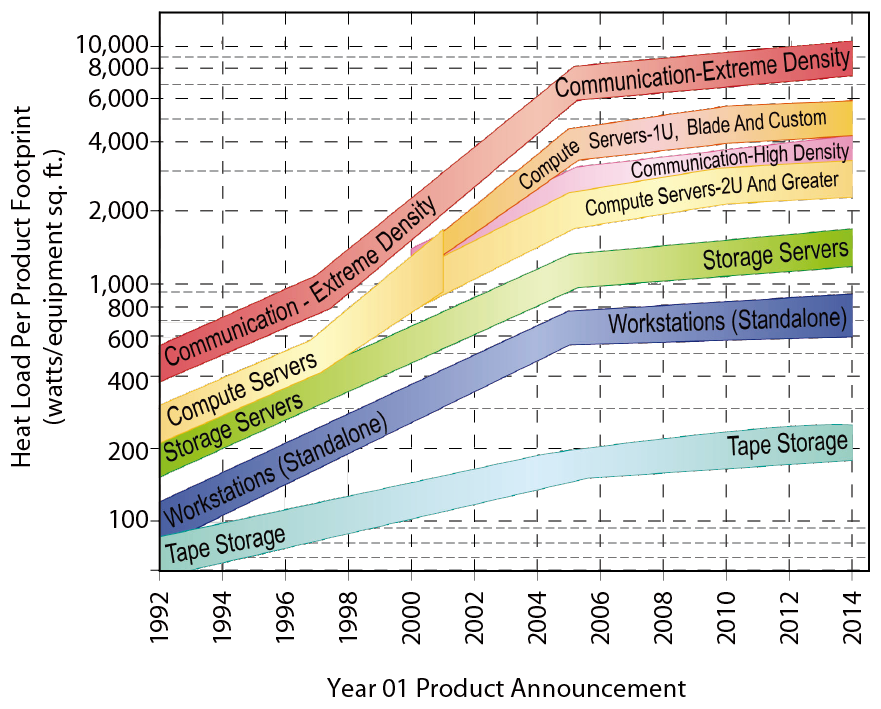

電腦機房耗電量因快速運算及雲端運算需求,單位面積的耗電量已大於一般辦公大樓的100~200倍,其中機櫃耗能約佔52%,空調39%,照明2%,不斷電系統損失7%[1],以美國為例,目前電腦機房所消耗的電力已佔到美國全部電力使用量的2%,預計到2020年,此數字將激增到9%,圖一顯示各型式電腦機房之耗電比例。

圖一、電腦機房耗電比例[2]

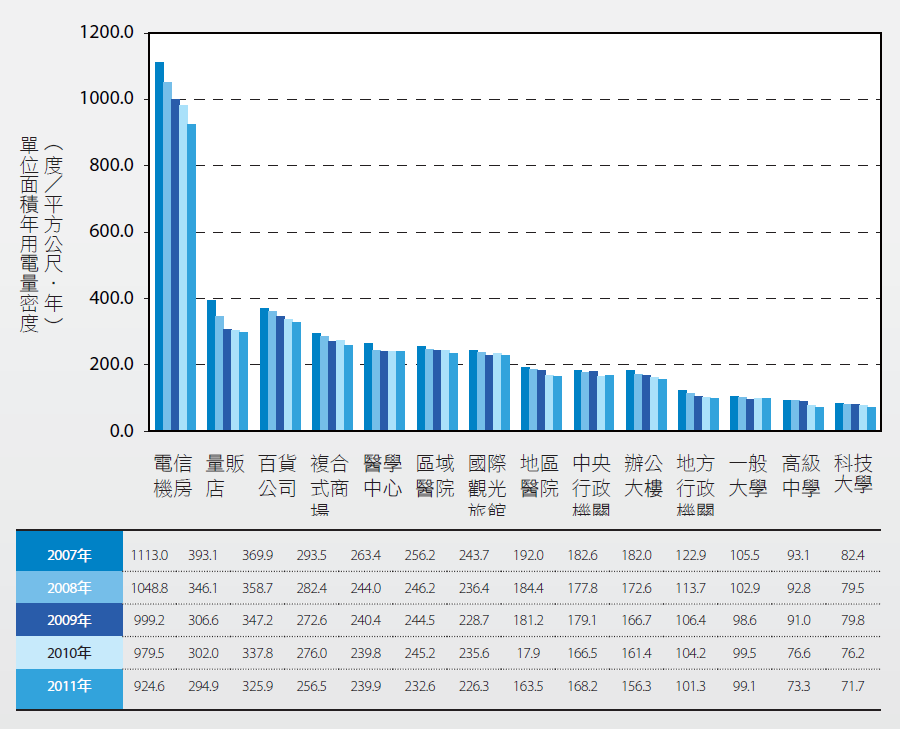

依照經濟部能源局委託台灣綠色發展基金會調查之2012年非生產性質行業能源查核年報中顯示,電腦機房之單位面積年用電量密度(Energy Use Intensity, EUI,為單位面積年用電量密度kWh/㎡•yr,以建築物之年用電量除以總樓地板面積)最高,但是近年來因大家的重視與改善,它的節能效益也最高,如 圖二所示。

圖二、近五年單位面積年用電量密度(EUI) 變化統計圖[3]

世界上設置伺服器最多的是微軟,超過100萬台,其次是Google 90萬台,Facebook 15萬台,Yahoo 10萬台,Intel 7.5萬台, 圖三表示最繁忙知網站使用率。本文分析電腦機房之空調、電力系統設計方式,比較其優缺點,並以網路使用率最高之廠商Facebook、Google及網路設備供應商Intel之機房討論其設計方式,從中找出節能的方法,以應用在我們未來的建廠設計上。

圖三、最繁忙的線上網站(04/2012 資料)[4]

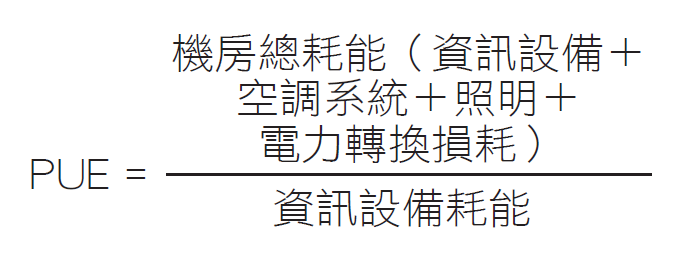

非營利組織Green Grid協會定義電腦機房之電源使用效率指標PUE (Power Usage Effectiveness)為耗能指標,指電腦機房的總耗電量與IT設備本身的耗電量之比,此數值越低越好。

Green Grid協會針對「電腦機房能源使用合理化」,訂定了PUE耗能指標,使用300RT以上中央空調冰水主機系統的電腦機房,只要PUE值達到1.52以下,即可取得申請LEED綠機房的基本門檻。

美國環保署EPA公布的數據顯示,全球的電腦機房平均PUE為1.91~2.1;Uptime公布的資料,平均PUE為1.8,台灣因地處亞熱帶且能應用節能手法較少,平均約在1.9以上, 表一為國際及相關廠商之PUE比較。

|

國際平均 |

日本平均 |

|

|

Intel |

Microsoft |

中華電信板橋綠機房 |

|---|---|---|---|---|---|---|

|

1.8~2.1 |

1.8~2.0 |

1.07 |

1.21 |

1.28 |

1.21 |

1.5 |

隨著國內電價的調漲,如何節能抗漲、降低電腦機房之耗能、提高能源之使用效率,儼然成為新世代電腦機房設計、施工、營運及管理單位的重要目標。然而,機房設計之考量主要在其穩定性及可靠性,而不僅是能源效率,如何在二者之間取得平衡,乃是現在重要的研究方向。

電腦機房發展

電腦機房隨著資訊產業日益發達,資訊產品的運用及電腦計算能力與儲量負載的發展技術也不斷地精進,網路應用的急遽增加,對於頻寬需求的增加,導致企業機房的數量、規模和密度也隨之擴大,在高密度的資訊設備運作下,一方面必須提供大量的電力驅動資訊設備本體,另一方面亦須供應龐大的電力在設備的冷卻系統,以維持資訊設備更有效率的持續運作;因電費之高漲,電腦機房使用者亦開始致力於省能的運轉狀態改善。

機房主要設備包含路由器(Router)、轉換器(Switch)、虛擬私有網路(VPN)、防火牆(Firewall)等核心網路設備;電子郵件系統、入口(Portal)、企業營運資訊系統等伺服器;Web-Hosting、網路學習系統等資訊交換中心;以及網路儲存主機、備援主機的所在。為提高營運績效,電腦機櫃效能越來越高,體積也越來越小,在高密度的設備運作下,一方面除需提供足夠的電力供應設備本身外,亦須供應龐大的電力在電腦設備的冷卻環境,以維持這些設備的持續運作。

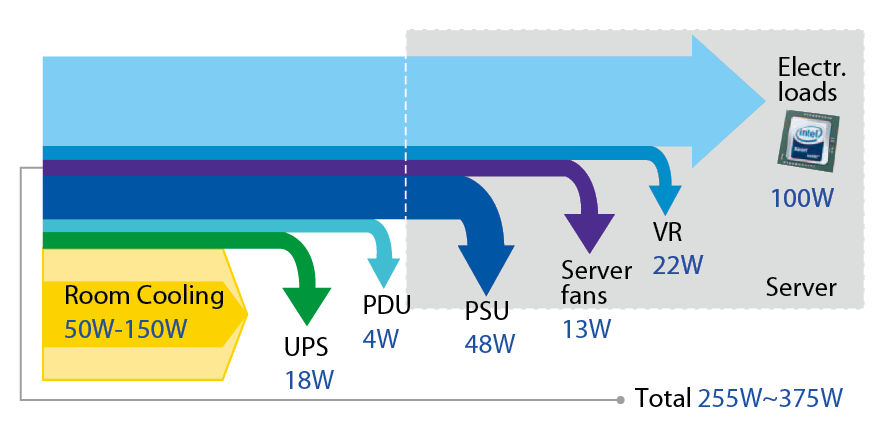

電腦機房依耗電分析,欲供應100W伺服器所需之基礎架構及冷卻需耗掉200~300W電力,減少基礎設施耗電是省能最佳方法,如 圖四所示。 圖五顯示未來之電腦機房設備用電量逐步上升,規劃上必須考慮未來的擴充性,以滿足其需求。

圖四、電腦機房耗能分析[5]

圖五、未來電腦機房設備用電需求[6]

目前半導體廠的電腦機櫃(Rack)用電密度約8~15 kW/rack,未來將會達到30~50 kW/rack,如何提供穩定的電力、冷卻能力,並將節能手法導入,使其成為綠機房,是一大挑戰。

機房運轉環境條件

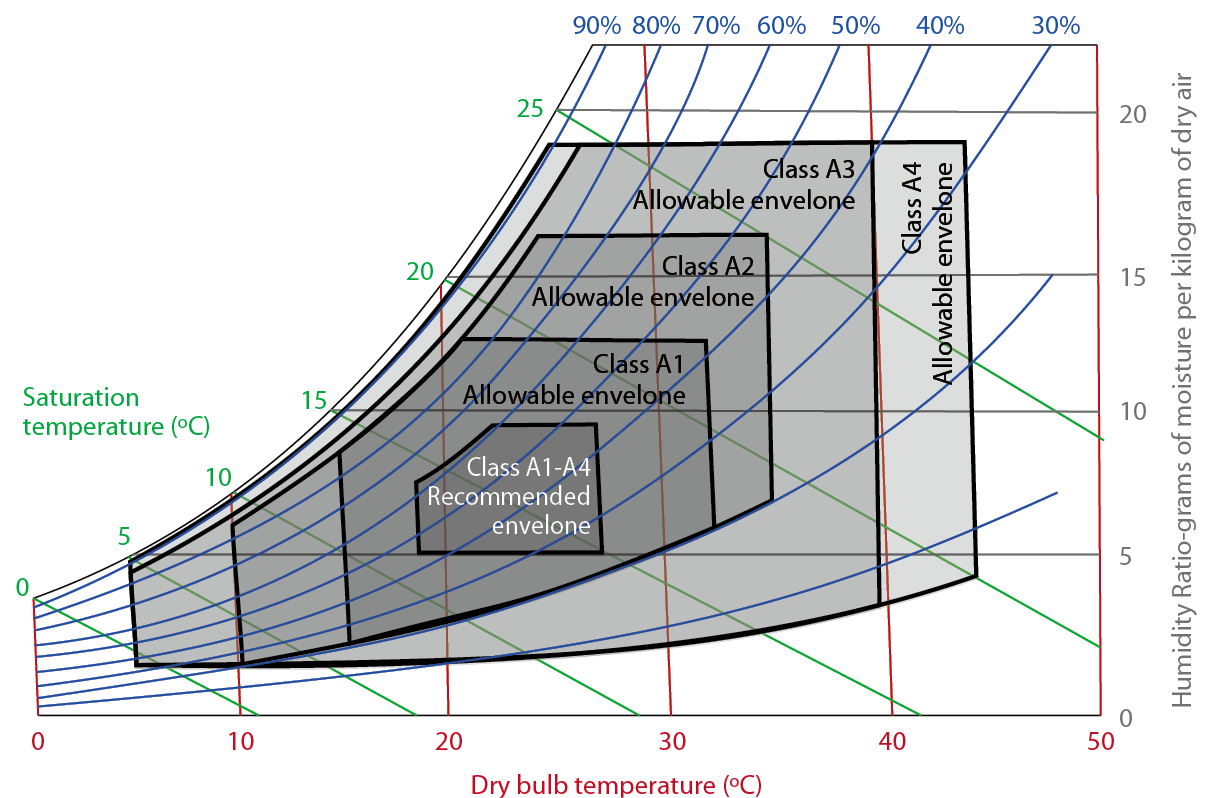

美國冷凍空調協會(American Society of Heating, Refrigerating and Air-Conditioning Engineers, ASHRAE)於2004年提出一版機房空調條件設定標準,並於2011年改版,提供環境條件更大的容許度,共分為4個等級,環境等級要求如 表二所示[7]。

|

Class |

建議運轉範圍乾球溫度 |

容許運轉範圍乾球溫度 |

最大露點溫度 |

|---|---|---|---|

|

A1 |

18~27°C 5°C露點溫度度60% RH |

15~32°C 20~80% RH |

17℃ |

|

A2 |

18~27°C |

10~35°C 20~80% RH |

21℃ |

|

A3 |

18~27°C |

5~40°C -12°C露點溫度、8~85% RH |

24℃ |

|

A4 |

18~27°C |

5~45°C -12°C露點溫度、8~90% RH |

24℃ |

等級一(Class A1)

屬於室內空調狀況(如乾球溫度、濕球溫度、相對濕度)需控制較嚴謹者,通常使用在企業營運伺服器或儲存用資料庫等。

等級二(Class A2)

屬於IT設備、辦公室、圖書館等區域須作部分環境控制者(如乾球溫度、濕球溫度、相對濕度),通常使用在小型伺服器、小型儲存用資料庫、個人電腦工作群組等。

等級三(Class A3)

屬於辦公室、居家、交通運輸等區域具備簡單控制者(僅溫度控制),通常使用在個人電腦群組、膝上型電腦、影印機等。

等級四(Class A4)

屬於使用端的設備、電腦、PDA等。

Class A1是管控最嚴格的環境等級,容許IT電腦機櫃內乾球溫度介於18~27℃之間,露點溫度5℃,相對濕度60%,入風溫度可容許範圍於15~32℃之間,相對濕度容許範圍於20~80%之間。以空氣線圖畫出其適合之操作區域如 圖六所示。

圖六、ASHRAE Class A1~A4 容許空調操作環境

空調系統設計

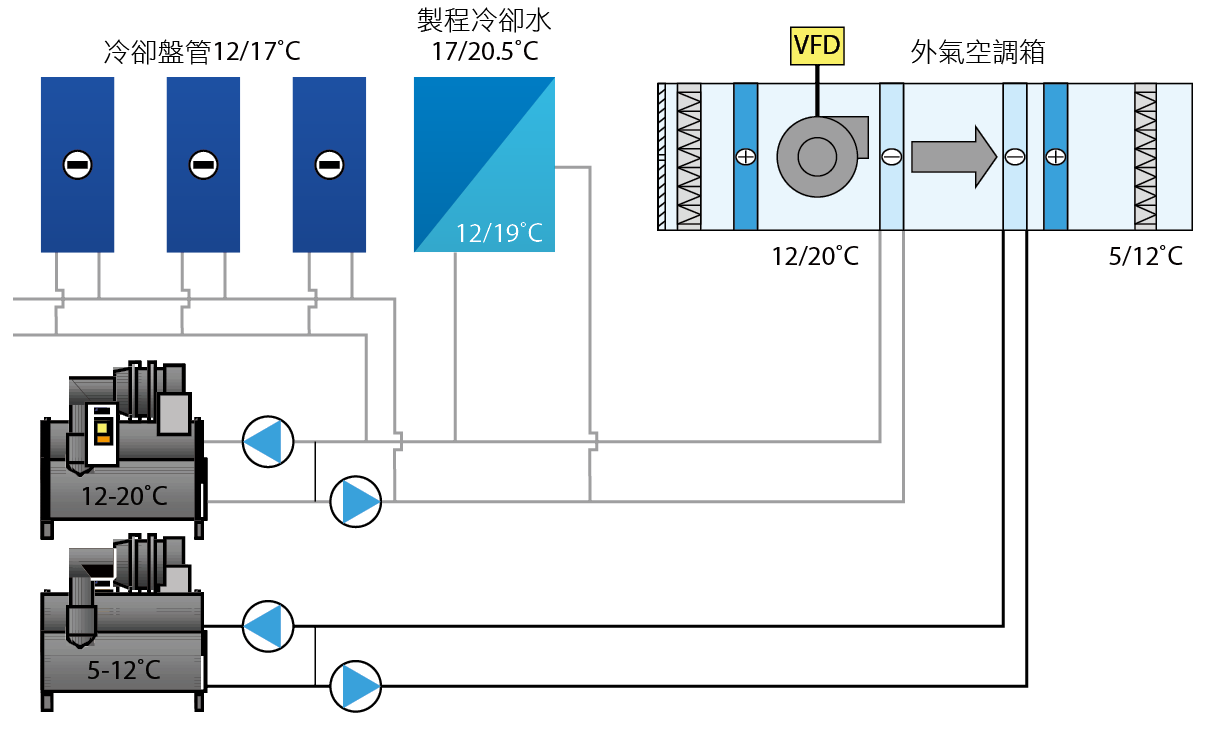

空調系統主要之組成元件包含製冷系統、散熱系統、送風系統及外氣系統等四大項,製冷系統示意圖如圖七所示,電腦機房一般使用冰水及送風設備等冷卻方式進行降溫。

圖七、製冷系統示意圖

冷凍空調協會制定電腦機房熱能環境指導手冊(Thermal Guidelines for Data Processing Environments)針對機房空調設計有詳盡之介紹,其中包括:

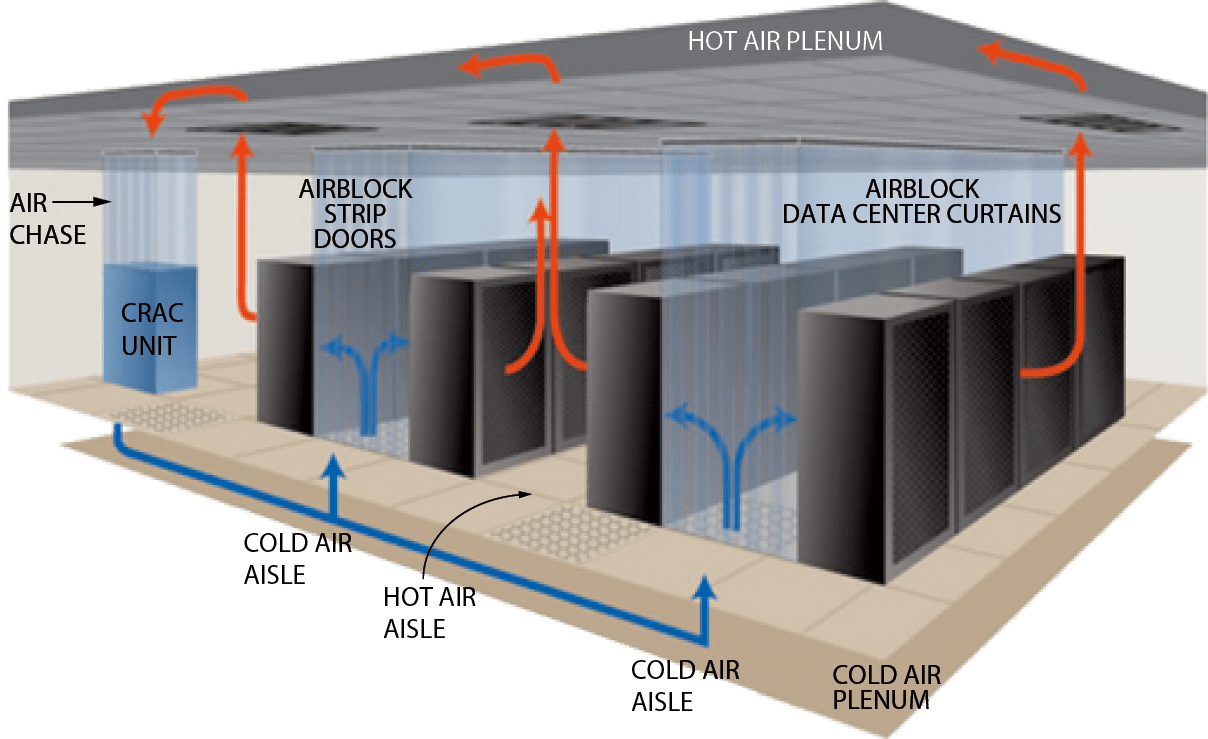

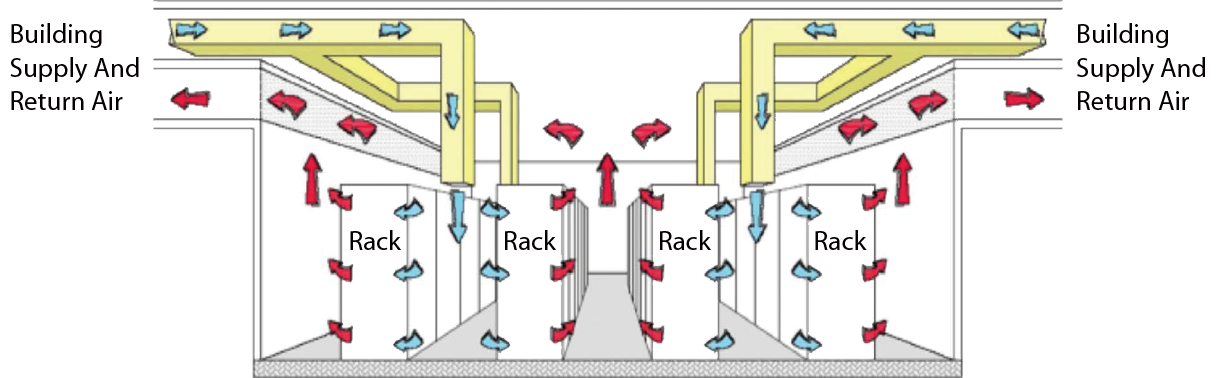

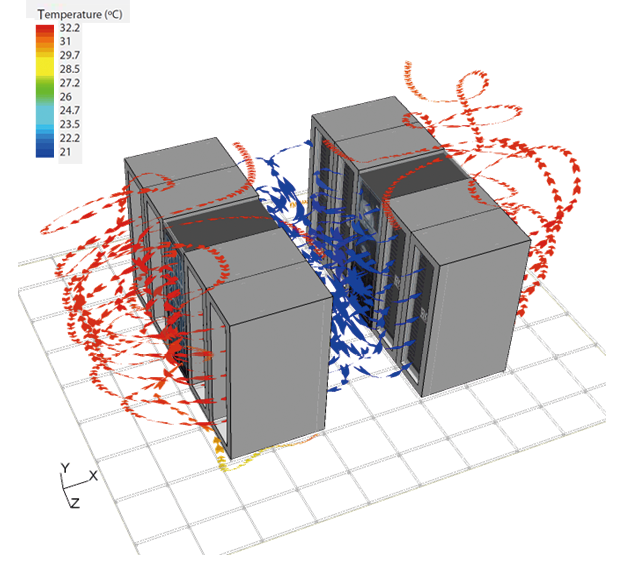

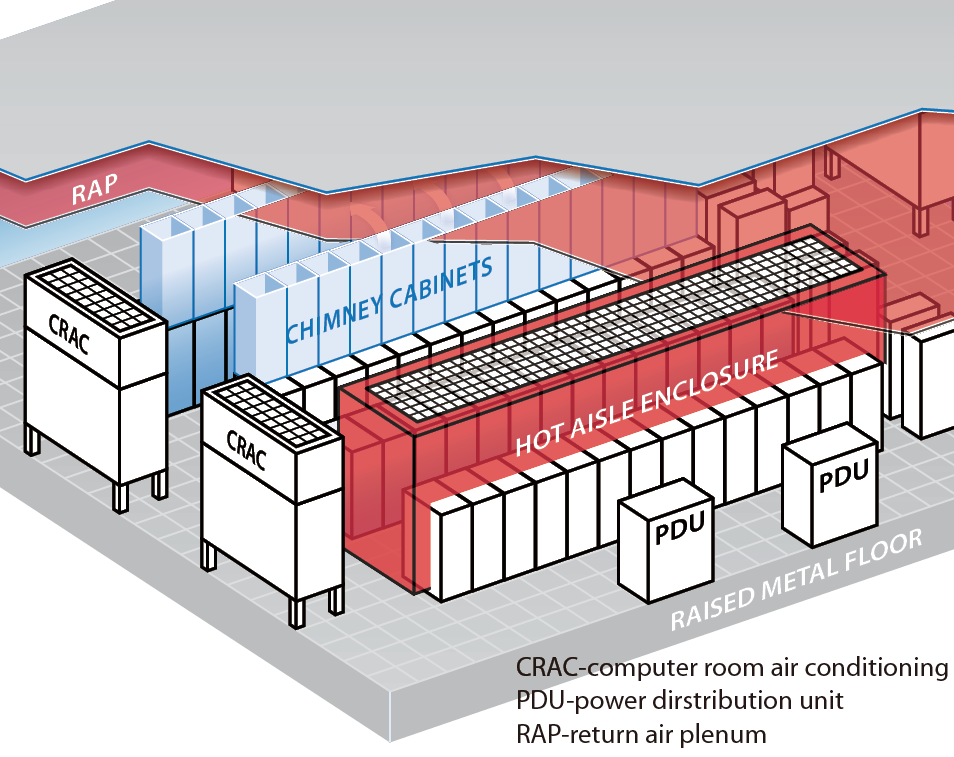

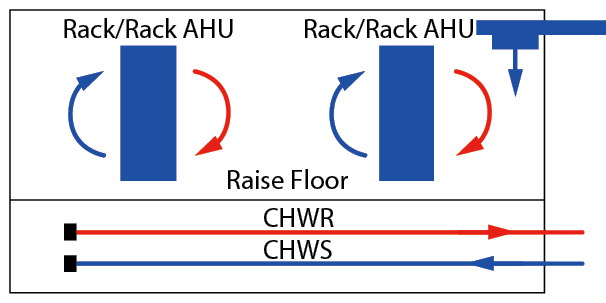

冷熱通道分離方式

機櫃擺設適當位置,使室內氣流形成冷通道與熱通道的氣流模式,如 圖八、圖九所示,利用高架地板將冷空氣送出至冷通道內,再由天花板回風;分流的作用在引進最大的冷空氣進入電腦機櫃內,並將熱氣導引至環境中,再回至電腦機房空調箱中冷卻,冷、熱通道必須隔離減少冷熱空氣發生混風現象及熱氣再循環問題。

圖八、冷熱通道空調氣流模式

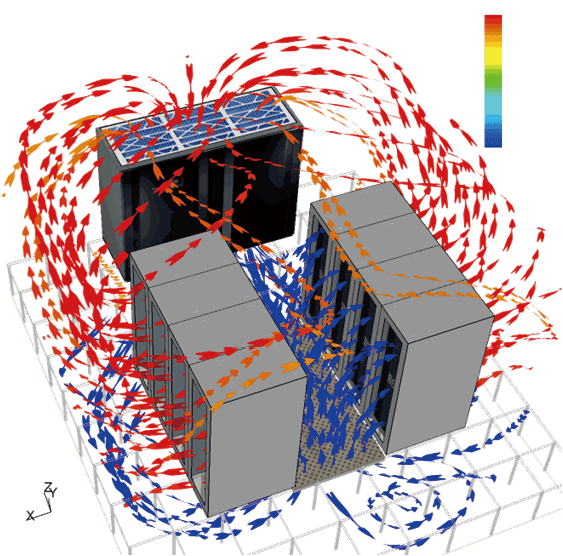

圖九、冷熱通道氣流分析

現在電腦機櫃因運算速度要求,僅有3~5年壽命,更換新機櫃時因高架地板下線路不易抽換,日積月累將導致送風通道阻塞,無法達到冷卻之要求,造成局部熱點(Hot spot)現象,空調必須送出更多的風或降低送風溫度,依中國技術服務社節約能源技術手冊[8]與綠色生產力基金會空調系統管理與節能手冊[9]得知調降冰水出水溫度1℃必須額外消耗壓縮機耗電1.5~3%,意謂混風問題會同時造成空氣側與冰水側雙方面的能源損耗,形成不必要的浪費。

風管送風及回風方式

為減少上述高架地板送風遭管線及出風口等阻擋之問題,改以天花板風管上出風設計方式,送至冷通道內,熱空氣則由自然回風方式導引至空調箱內,可使機房之混風現象減輕。冷熱空氣分離程度越高,節能效果越佳,如 圖十所示。

圖十、風管送風模式

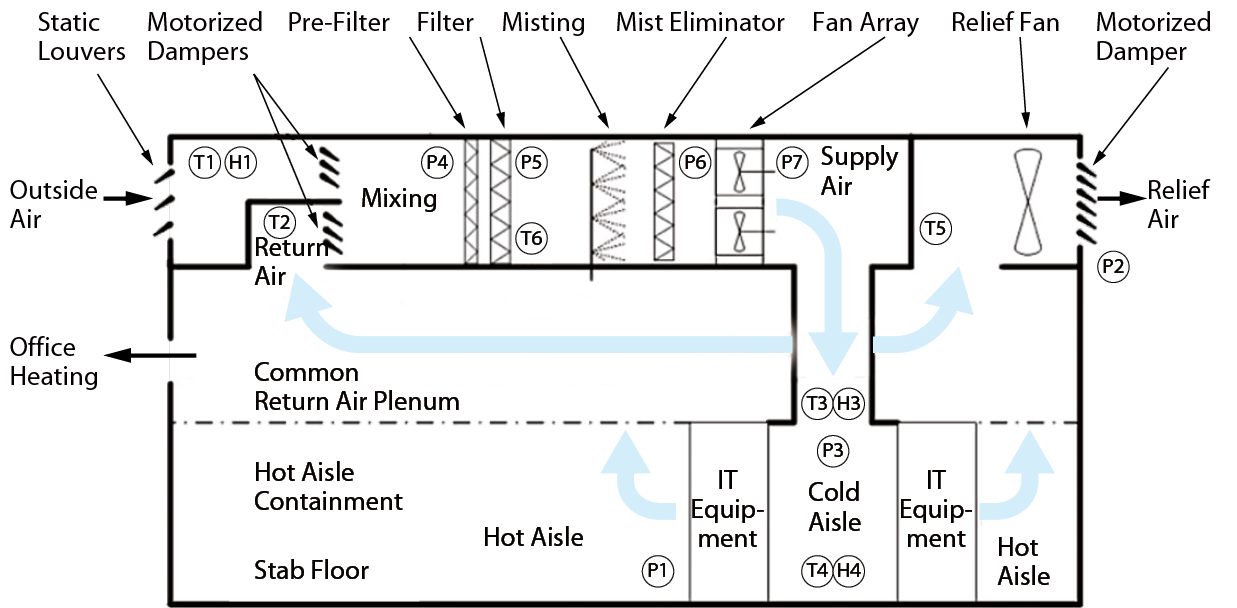

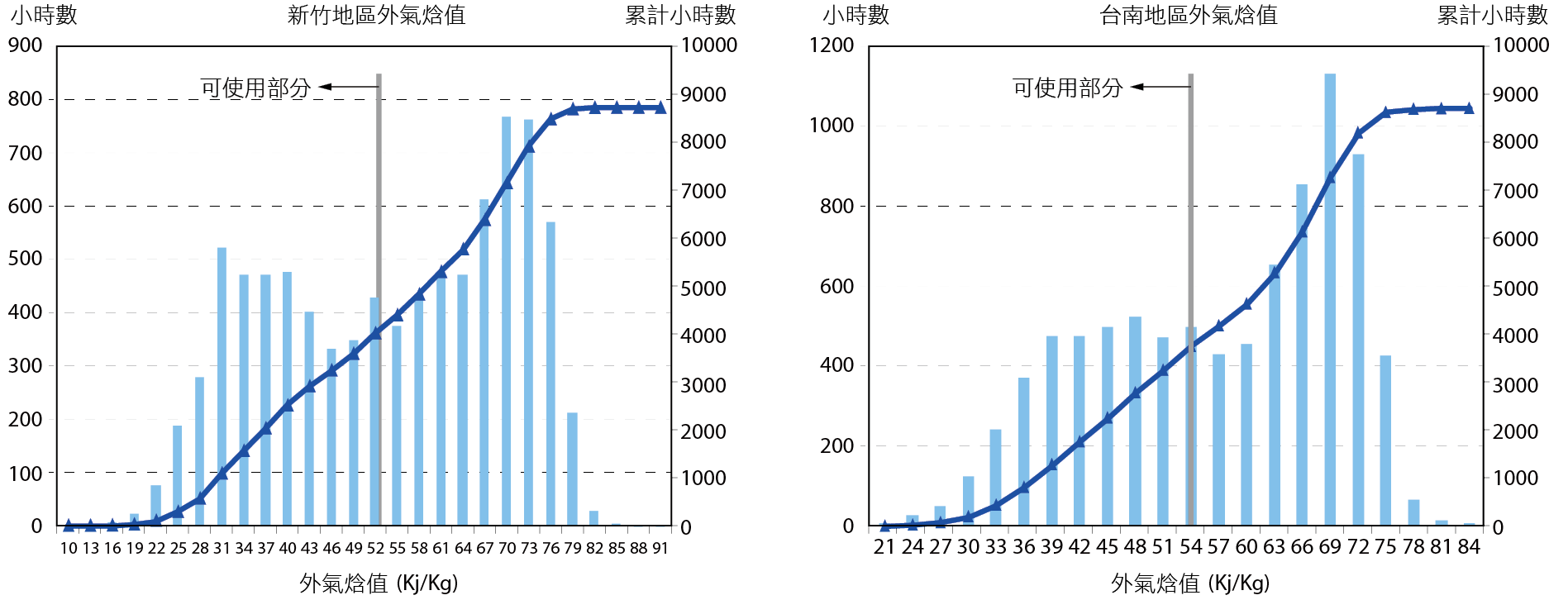

自然冷卻方式(Free cooling)

電腦機房設備可接受的機櫃入口氣流溫濕度條件很廣,在較精密的機房中,乾球溫度26℃,相對濕度50%都是可接受之範圍。台北市全年外氣低於乾球溫度26℃、相對濕度50%之焓值時間約有40%,因此可利用自然大氣環境之低能量源作為電腦機房之冷源,以減少空調主機之運轉時間,達到節能之目的。焓值愈低,利用外氣之冷卻效益愈高。台灣地區氣候相對炎熱,僅適合在春、秋、冬季時期應用。自然冷卻可分為空氣側自然冷卻及水側自然冷卻兩種方式。

空氣側自然冷卻

利用風機將符合電腦機房環控條件之大氣環境的冷空氣引入電腦機房以提供部分或全負載之機房冷卻,可利用風門擋板,進行外氣與回風之混合比例調整。系統可根據外氣、回風的溫度及相對濕度之偵測值進行焓值計算結果,來決定空氣側自然冷卻之啟動時機,若外氣焓值比回風溫度低,表示外氣對於機房具有冷卻效果,反之則不引進外氣,如 圖十一所示。

圖十一、空氣側自然冷卻流程[10]

以半導體廠房林立的竹科、南科為例,如 圖十二,可利用自然冷卻的時數約佔全年46%及37%,但因園區工廠密度高,空氣品質較一般非工業區差,必須考慮相關之空氣品質,進行妥善的處理後才可送入機房,避免減低電腦機櫃之使用壽命。

圖十二、新竹、台南全年外氣焓值分佈

水側自然冷卻

利用低乾球溫度或低濕球溫度之外氣,將冷卻水降溫至可符合機房冷卻之條件,以提供機房冷卻所需,部分取代或全部取代製冷主機之冷卻量,而達到節省製冷主機之耗能。分為直接自然冷卻及間接自然冷卻方式,直接自然冷卻節能系統之可利用時間與節能空間較大,但因會有管排之結垢與清潔之問題,建議採用間接自然冷卻節能系統;間接自然冷卻方法是當外氣條件足夠低時,將冰水主機系統之冷卻水經過冷卻水塔降至低溫條件,然後利用熱交換器間接冷卻冰水迴路,降低製冷主機之冷卻負載,以達到節能之目的,若冷卻水水溫足夠低,則有可能停止製冷主機之運作。

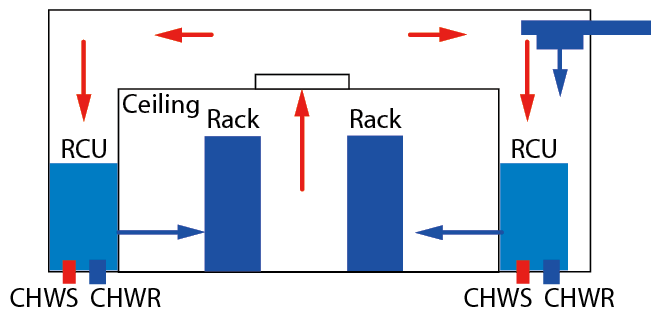

液體冷卻散熱方式

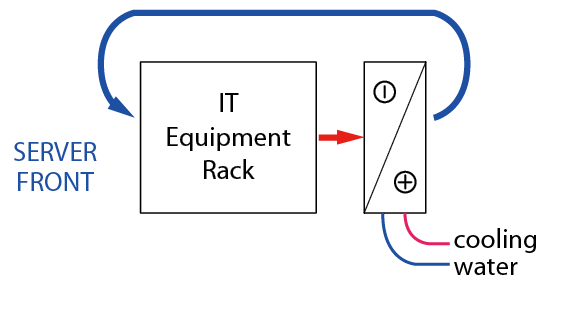

液體熱交換能力比氣體熱交換能力好,耗能較少(氣體對液體之耗電馬力數比為14.36 [11]),而且所需體積小,近來很多設備廠商引進水冷式冷卻系統,但因電腦設備相當怕漏水,因此水質要求及漏水預警系統必須嚴格要求,ASHRAE TC9.9 2011 Thermal Guidelines for Liquid Cooled Data Processing Environments有詳細之相關規定須遵循,如 圖十三所示。

圖十三、冰水供應示意圖

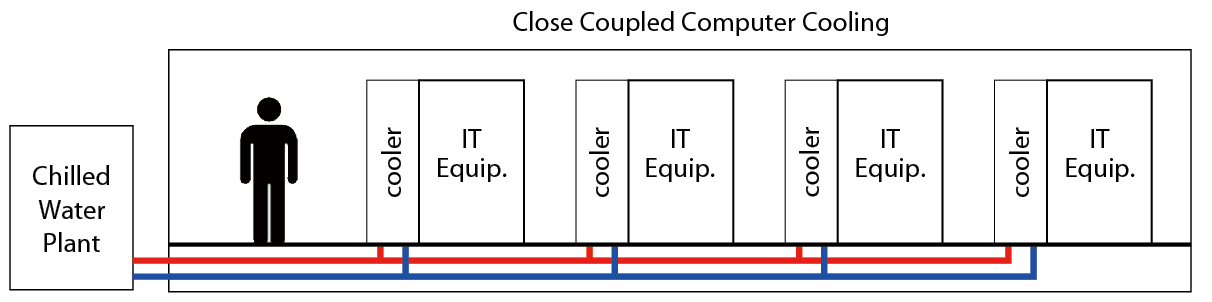

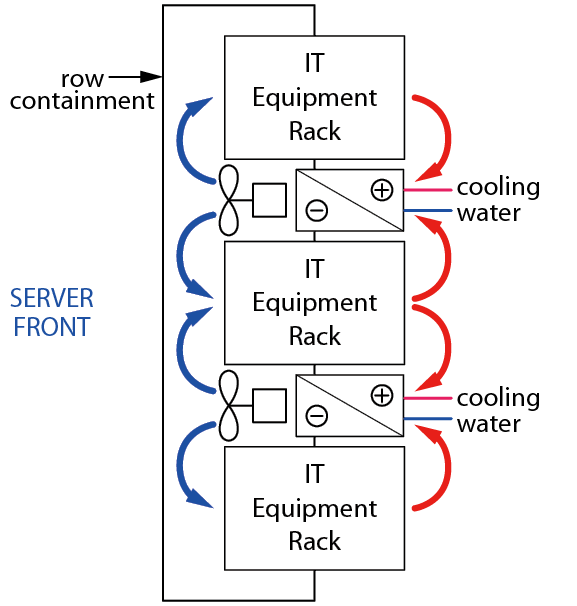

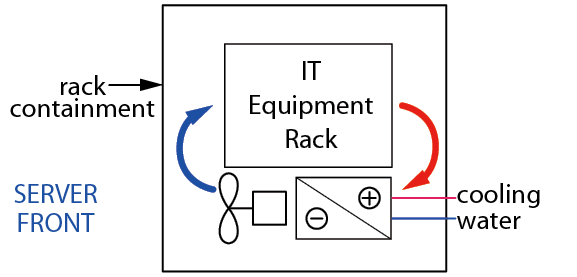

分為三種型式,包含機櫃式冷卻(Row cooler)、機櫃內冷卻(Rack cooler)及背板冷卻(Passive door cooler)等系統,如 圖十四、十五、十六、十七所示。

圖十四、機櫃式冷卻(Row cooler)

圖十五、機櫃式冷卻方式氣流分析

圖十六、機櫃內冷卻(Rack cooler)

圖十七、背板冷卻(Passive door cooler)

電腦機房之空調設計方式比較

依照目前使用量最大之電腦機房廠家如Facebook、Google、Intel之介紹,其空調方式各有不同,我們分析其差異性:

Facebook 於美國Oregon Prineville設立第一座約13,686m2的電腦機房,採用外氣自然冷卻系統,並控制環境之濕度,避免結露或靜電之問題,確保空氣溫度介於18.3~29.4℃,以及低於65%之濕度,此座機房外氣由屋頂外氣風機處理後直接送至機房,完全不使用風管,採用熱通道封閉方式,自然回流至屋頂與新鮮風混流,再供應至機房。它的PUE值可達到1.07。[12]

Facebook的電力系統採用480/ 277V供電,48V DC UPS供應伺服器機櫃使用。室內採用匯流排供應至主盤及各配電盤,每盞照明燈採用感應式LED燈,減少人員不在之耗能。

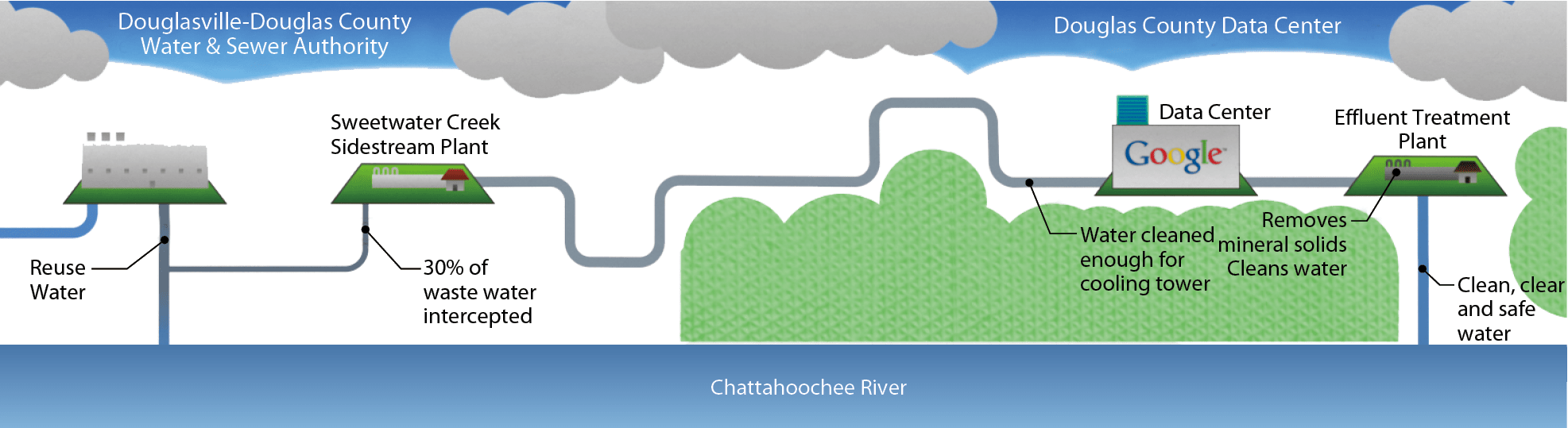

Google大部分購買靠近河邊或海邊廢棄之廠房設置電腦機房,採用蒸發冷卻的方式來降低空調冷卻的費用,冷卻水可採用河水、海水及再生水,透過過濾系統淨化水質,供給冷卻水塔使用,減少機房的用水。

Google有一座位於美國Georgia Douglas的電腦機房,位於Chatta-hoochee河附近,與當地環保局(Water and Sewer Authority, WSA)合作,建立一套系統回收水系統,引進Google的冷卻設施裡,他們在距離電腦機房8公里處蓋了一個廢水回收廠,處理後送進電腦機房冷卻系統。在電腦機房熱交換後,放流水進入另一個處理廠進行殺菌、過濾,水質符合排放標準後,排入Chattahoochee河裡,如 圖十八所示。

圖十八、Google 電腦機房引用河水冷卻示意圖[13]

Intel

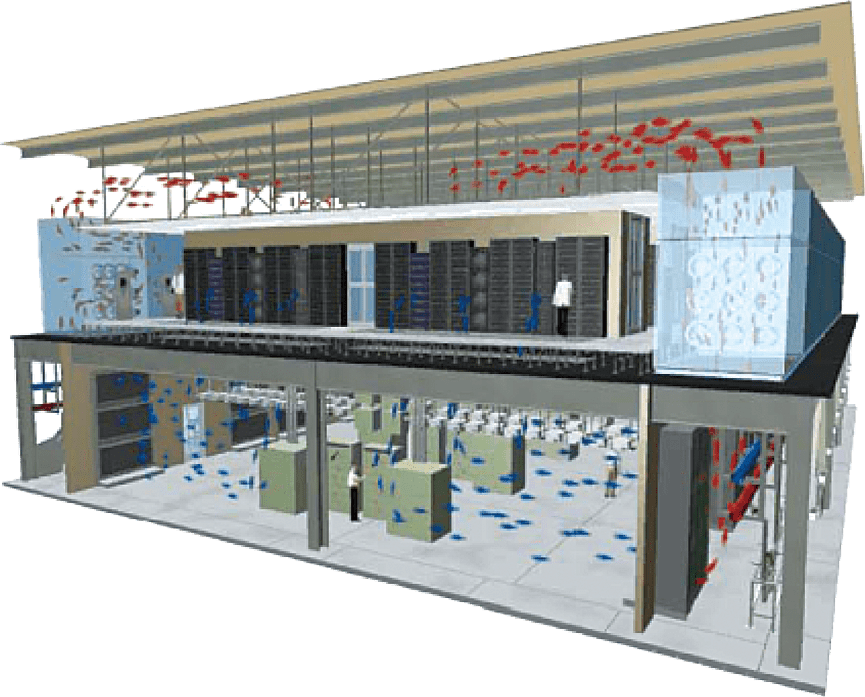

IIntel位於Oregon Hillsboro的高密度電腦機房JFS1,建築物為2層樓建築,一樓為基礎設施,二樓才是電腦機房,每間機房面積557m2,冰水採用chiller plant方式供應,冷卻採用電腦機房空調機(CRAC及CRAH),利用冷熱通道分離方式,配置相當之溫濕度感應器,確保送風溫度為25.5℃,回風設計為35~41℃,當熱風溫度偏高無法使用時,利用調節器排至戶外,如 圖十九、二十所示。Intel研究報告指出熱通道封閉是最佳的方式,其優點有:[14~16]

圖十九、Intel 電腦機房空調架構

圖二十、冷熱通道分離

- 冷熱風溫差(△T)較大,熱交換效率較佳。

- 人員工作主要在機櫃前方,環境較為舒適。

- 機房內電氣設備不需特別考量溫度對它們的影響。

目前Intel新建之電腦機房已取消高架地板之設置,其好處有:

- 不再有斜坡之設置及搬運困難度。

- 減少地板設置及維護費用。

- 不需考量斜撐之防震設計。

- 房間高度可降低。

- 不需地板下之消防及漏水檢知設備。

彙整各廠商之空調設計方式及操作條件如 表三所示。

|

Class |

|

TSMC CCD room |

Intel Server room |

|---|---|---|---|

|

空調方式 |

|

|

|

|

發熱功率密度 |

95kW/Rack (Est.) |

12kW/Rack |

15~30kW/Rack |

|

室內操作條件 |

溫度:<27°C 相對濕度:20-80% |

溫度:18-26°C 相對濕度:≦60% |

溫度:25°C 相對濕度:20-80% |

|

冰水溫度 |

冰水供水:21.1°C 冰水回水:36.1°C (∆T=15°C) |

冰水供水:5°C 冰水回水:13°C (∆T=8°C) |

N/A |

|

冰機耗能 |

0.354 kW/RT |

0.63 kW/RT |

N/A |

|

說明 |

高溫差:冰水流量低,泵送耗能低。冰水機耗能低。 |

低溫差:冰水流量高,泵送耗能高。冰水機耗能高。 |

N/A |

電腦機房電力系統設計

由於電腦機房的重要性,它所提供的服務之可靠性、正確性、穩定性更加重要,美國國家標準學會(ANSI)和美國通信工業協會(TIA)發佈TIA-942資料中心的通信基礎設施標準 (Telecommunications Infrastructure Standard for Data Centers),做為電腦機房設計準則,包含四個層次:空間規劃、佈線規範、可靠度等級、環境考量,是第一個電腦機房的技術規範標準,它為現代機房工程提出了新的設計理念、系統架構與技術指標。

TIA-942提出相對應的廠務基礎設施(電源配置、冷暖空調、及其他附屬系統)分為四個等級,分別是:Tier I沒有多餘備援機機制組成的系統(提供99.671%穩定性)到Tier IV有充足備援元件(能夠故障容錯)和實現不停電維修的系統(提供99.995%穩定性)。其備援方式彙整如 表四。

|

Number of delivery paths |

Tier I Only 1 |

Tier II Only 1 |

Tier III 1 active 1 passive |

Tier IV 2 active |

|---|---|---|---|---|

|

Redundant components |

N |

N+1 |

N+1 |

2 (N+1) or S+S |

|

Utility voltage |

208,480 |

208,480 |

12-15kV |

12-15kV |

|

Annual IT downtime due to site |

28.8 hours |

22.0 hours |

1.6 hours |

0.4 hours |

|

Site availability |

99.671% |

99.749% |

99.982% |

99.995% |

|

資料來源:The Uptime Institute |

||||

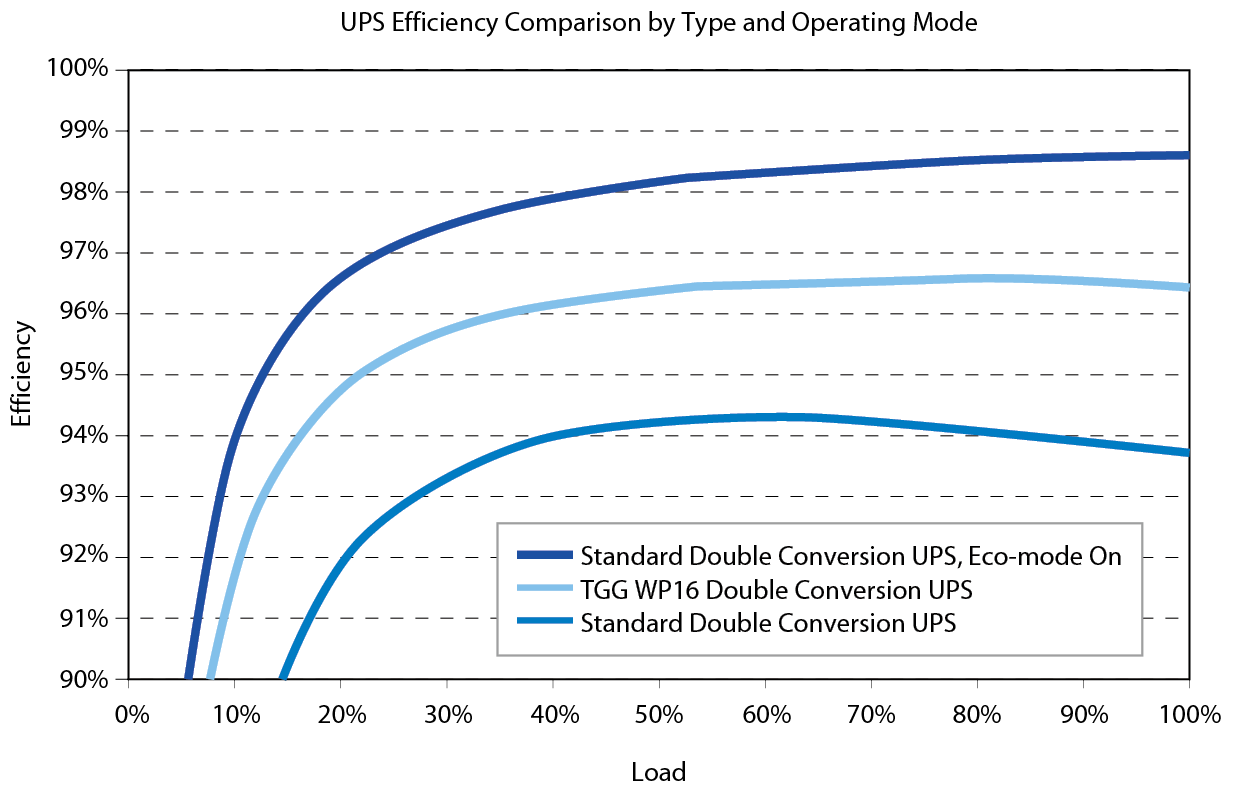

不斷電系統(Uninterruptible Power Supply, UPS)是維持電腦機房運作的一大核心,當電源供應有異常時(壓降或斷電),可由UPS提供短暫的供電,避免機房功能喪失。因其必須涵蓋所有電腦機櫃的用電量,甚至為2倍容量,以提供2~10分鐘之用電需求;UPS可分為在線式(On-line)、離線式(Off-line 或eco mode)及在線互動式(Line interactive),一般UPS其整機滿載效率大約在92%~96%,半載時效率較低,減少約2.5~6.5%,如 圖廿一,離線式效率因平時不經過交直流轉換,當偵測到壓降或斷電時,在4ms內進行切換,改由電池供電,可增加4~5%能源利用率,目前工廠生產機台之UPS均已經過測試,離線式可在電力壓降時維持其正常運作。

圖廿一、UPS 轉換效率─負載率越低整機效率越低

以台積電常用之Eaton 825 kVA及Delta 500 kVA UPS比較,如 表五所示,換算成相同之825 kVA,以全載在線式為基準,Eaton離線式一年電費可省98萬,Delta 離線式一年可省66萬,若是半載狀況下,Eaton在線式一年需多花21萬,Delta在線式一年需多花31萬,以效能來講,Eaton可節省之電費較Delta為多。

|

UPS型式 |

模式 |

效率 |

年耗電電費 |

換算成825 kVA年耗電電費 |

年電費差距 |

差距% |

|---|---|---|---|---|---|---|

|

Eaton 825 kVA p.f.=0.9 |

全載在線式 |

94.0% |

19,387,557 |

19,387,557 |

- |

- |

|

全載離線式 |

99.0% |

18,408,388 |

18,408,388 |

-979,170 |

-5.1% |

|

|

半載 |

93.0% |

19,596,026 |

19,596,026 |

208,468 |

1.1% |

|

|

Delta 500 kVA p.f.=0.8 |

全載在線式 |

92.5% |

10,606,703 |

19,701,950 |

314,393 |

1.6% |

|

全載離線式 |

97.3% |

10,083,453 |

18,730,014 |

-657,543 |

-3.4% |

|

|

半載 |

92.8% |

10,572,414 |

19,638,259 |

250,701 |

1.3% |

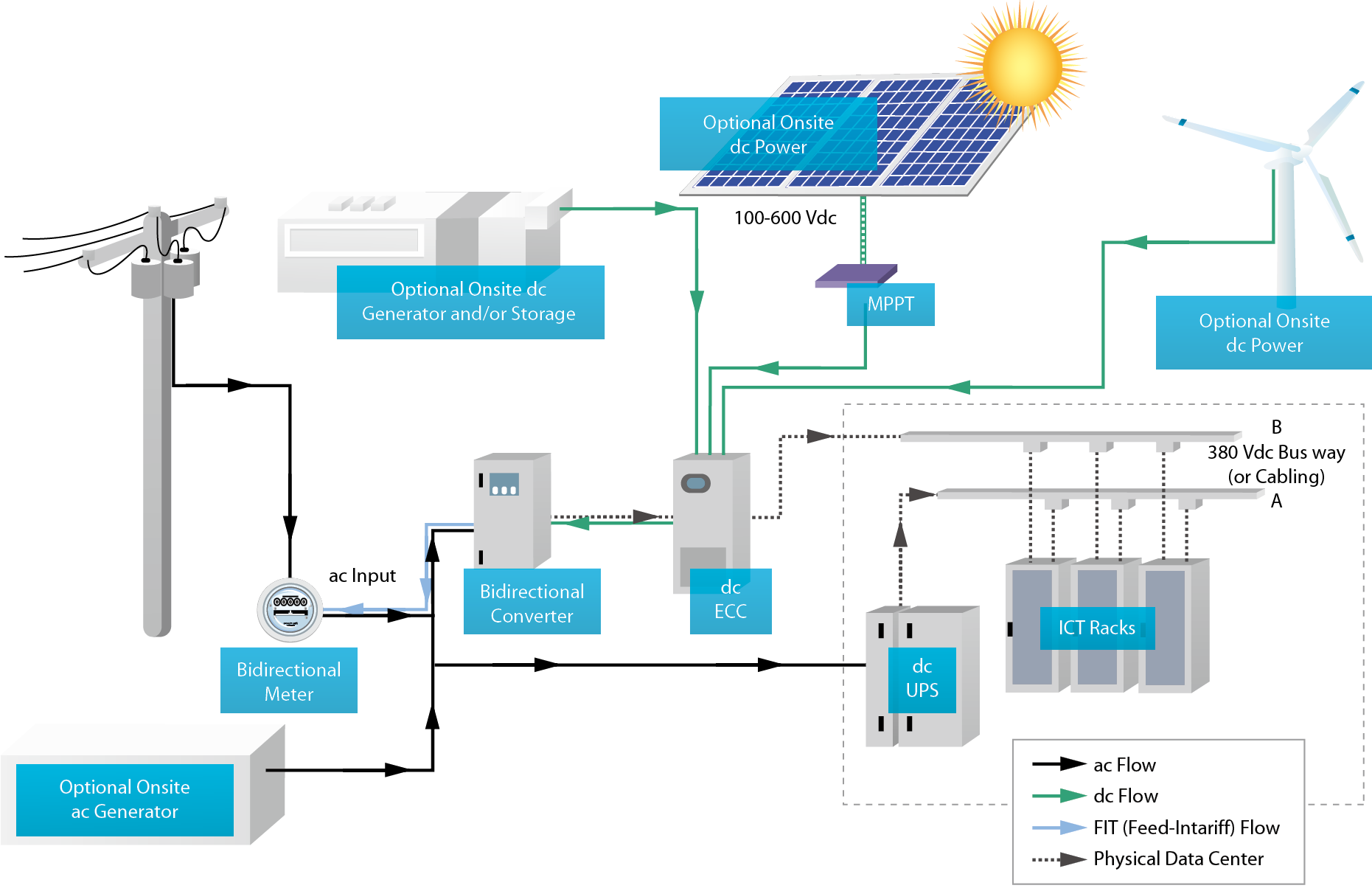

直流(DC)供電之可行性

圖廿二、直流供電系統示意圖[5]

傳統的UPS設計架構,從市電通過UPS設備,經變壓後送至配電櫃(Power Distribution Cabinet,PDC)分配電力需求,最後輸送給IT設備的過程中,至少需要經過三次交/直流轉換。包括交流(AC) UPS的兩次交直流(AC/DC)轉換、伺服器中電源供應單元(Power Supply Unit)的AC/DC轉換以及PDU的降壓變壓器,所產生的能源轉換損失大約在10%-20%之間。都讓整個交流供電的效率低落。採用高效率的UPS設備雖然有助於改善損失,但成效仍不佳。低壓直流(LV DC)因傳輸距離及壓降問題,近來較可行採用的是高壓直流(HV DC)供電,高壓直流供電除了減少能源消耗之外,設備佔地面積、UPS檢修成本以及纜線成本都能顯著降低,另外,由於轉換的節點變少,架構更為簡單後,反而讓UPS的可靠度提升1倍。但是要確實達到直流供電,除了架構面之外,設備的支援也不可少,目前已有相當多的廠家設計出可支援380V HV DC的設備。依照目前瑞士Green Data Center供應商在蘇黎世測試的一個1,100m2的電腦機房,其獲得直流供電效益有:

- 10%能源效益之改善(不含減少之冷卻需求)。

- 15%電力供應系統之元件投資。

- 減少電力供應系統之元件,需要的機房空間可縮減25%。

- 無諧波之產生,運轉更安全。

目前之再生能源─太陽光電發電系統產出之電力亦為直流電,若由其直接供電給電腦機房將可減少更多之轉換損失。

節能手法應用

電腦機房之機櫃用電越來越高,耗電量也持續成長,可採用的節能方式有:

- 進行動態PUE量測:藉由量測能源消耗及PUE監測了解機房能源性能與效率,並隨時進行調整。

- 氣流監控:良好氣流管理是機房節能的基本,冷熱通道隔離減少混風,避免熱點發生及溫度調低或增大風量之浪費。

- 提高冰水送水溫度及機房溫度設定:依據ASHRAE建議調高環境設定溫度至20~25℃,相對濕度60%,降低冰水之消耗。

- 變頻器應用:使用變頻冰水主機、變頻冰水泵、變頻風扇、變頻冷卻水泵、變頻冷卻水塔。

- 使用自然冷卻通風,在焓值較低時引進,供應機房空調使用,改善能源效率。

- 空氣側、水側設置節能裝置(Economizer),提高回水溫度。

- 機房廢熱回收,回收熱氣做成熱水供應健身房淋浴、廚房熱水及冬天水龍頭熱水使用。

- 避免超量設計及冰水主機台數設計。

- 將未使用之機櫃予以密封,避免氣流短循環。

- 最佳化電力系統供應,使用高效率之變壓器(98%以上)及避免UPS過量設計,提高UPS負載率,減少能源損失。

- 空間足夠時將廠務設施與機櫃分離,可達最大坪效之使用。

以台積電某廠高密度電腦機房為例,分析Row cooler及CRAC之冷卻效益:

6間機房之耗電量為4.25MW,UPS發熱量因設置在外部,不考慮其發熱量,需要5.6kW之CRAC 53台或3kW Row cooler 100台。 因冰水為冰機房提供,其耗能相當,以耗電量及設置費用比較,100台3kW Row cooler設置費用為4,500萬,一年運轉費用為263萬,CRAC設置費用為1,325萬,一年運轉費用為260萬;每年運轉費用幾乎相近,雖然Row cooler設置費用高出3,175萬,假設空調機設置在電腦機房內,Row cooler面積(每間24m2)較CRAC(每間38m2)減少58%,將若能將空調設施移出機房外,以廠房建置費用每m2約3萬元,提供228m2(費用684萬),原本空間可設置更多之機櫃,CRAC供風方式將可減少3,000多萬的Row cooler設置費用,機房坪效將更佳。

結論

高密度電腦機房將是未來的趨勢,如何讓它不中斷供應也是台積電面臨的問題,所有廠務系統及運算儲存單元均需包含備援,導致設備裝置量均大上一倍,UPS運轉負載量僅在30~40%之間,其效率並不佳,採用離線式UPS可減少轉換損失,直流供電可提高使用效率、減少需要的面積。

相關廠務設施進行節能手法,及機櫃冷熱通道分離以外,自然冷卻通風方式是最節能方式,但必須考慮當地氣候條件及空氣品質,減少額外設置過濾系統。若能選擇在適當地點單獨設置一電腦機房,利用春、秋季節採自然冷卻方式,機房用電每年將可減少126萬以上。

參考文獻

- 北科大李魁鵬,電信機房節能應用技術。

- Lawrence Berkeley National Labs, Benchmarking: Data Centers, Dec 2007, http://hightech.lbl.gov/benchmarkingdc-charts.html

- 綠基會,2012年非生產性質行業能源查核年報。

- DCDA Consultant, Data center.

- Guy AlLee and William Tschudi, 380 Vdc Brings Reliability and Efficiency to Sustainable Data Centers.

- 林憲文、楊璉華,新一代機房管理。

- Thermal Guidelines for Data Processing Environments, 2nd Edition, ASHRAE Datacom Series 1, 2011.

- 經濟部能源委員會,節約能源技術手冊。

- 財團法人台灣綠色生產力基金會,空調系統管理與節能手冊。

- Humidity Excursions in Facebook Prineville Data Center, http://www.electronics-cooling.com/2012/12/humidity-excursions-in-facebook-prineville-data-center/.

- Otto Van Geet, Trends in Data Center Design – ASHRAE Leads the Way to Large Energy Savings.

- Jay Park, Open Computer Project Data Center v1.0.

- Google資料中心省錢法!引河水做冷卻,處理後排回河中,http://asset3.t17.techbang.com.tw/topics/12646-by-google-data-centers-to-save-money-water-cooled-rear-back-in-the-river.

- Paul Vaccaro & David Seger, Intel Corporation High Density Data Center An Operational Review.

- John Musilli & Brad Ellison, IT@Intel White Paper, Facilities Design for High-density Data Centers.

- Jay Kyathsandra & Chuck Rego, The Efficient Datacenter.

- 綠智網,Tier功能驗證。

- ABB Review, Data Centers Designed for Uptime, 2014.

- Emerson Network Power, Conducting an Accurate Utility Cost Analysis Based on UPS efficiency.

留言(0)